つづいてよしださんから、ここまで平野さんが話されてきた技術を、実際の現場や制作にどのように活用しているかを紹介していきました。

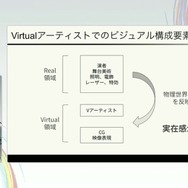

まず、バーチャルアーティストのライブについて、仕組みや流れを説明へ。バーチャルアーティストのライブには、「バーチャルライブ・ARライブ・リアル(現地会場)ライブ」の3つの形態があります。

3DCG空間内で完結しているパターン、現実のステージや場所を背景にいてバーチャルアーティストがライブをするパターン、現実のライブ会場でライブをして舞台上で映像表示をするパターン、このように分けられます。

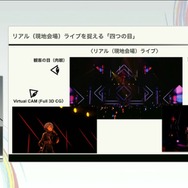

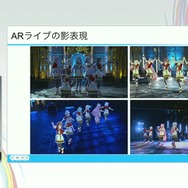

リアルライブを開催する際には、配信を通して視聴・観劇しているファンもいるため、実写カメラのみでなく、バーチャルカメラやARカメラも駆使しながら配信上でお届けしているかたちをとっています。

ここで、バーチャルアーティストのライブの仕組みについてよしださんは説明されました。

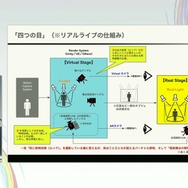

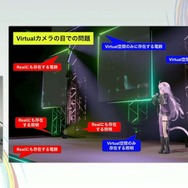

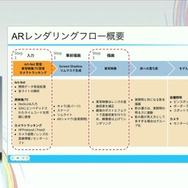

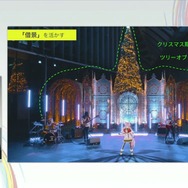

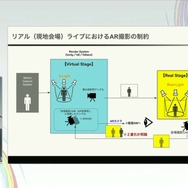

出演者(タレント本人)は、会場内に設置したモーションキャプチャーの収録エリア内でパフォーマンスを行います。モーションキャプチャーシステムと接続されているレンダリングシステム・バーチャル空間には、現実の舞台(ライブステージ)と視覚的につながるようなデザインのバーチャルステージを組み立てます。

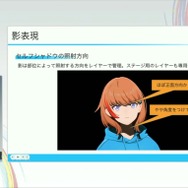

バーチャルステージにバーチャル照明を組み上げ、その照明の光を浴びてパフォーマンスをするタレント本人を舞台投影用のバーチャルカメラが捉えて、レンダリングと出力します。

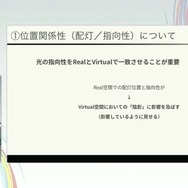

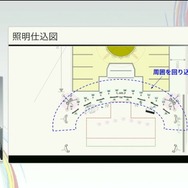

その出力した映像をリアル会場のステージへと描写するのですが、バーチャル空間で捉えていた照明はここでは非表示状態にしつつも、バーチャル空間で使用された照明とリアル会場の照明を置き換え、立体的に重ね合わせます。

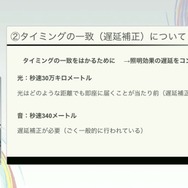

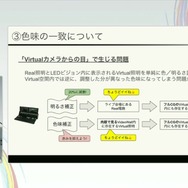

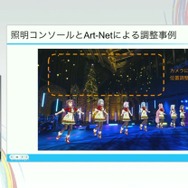

このとき、リアル会場の照明とバーチャル空間の照明が、色味や変化のタイミングを完全に一致させない違和感が残りますし、逆にうまく同期した動きを見せることで、「舞台上の照明でタレントが照らされている」ように見えるわけです。

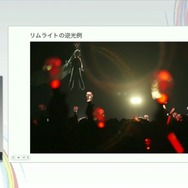

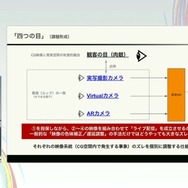

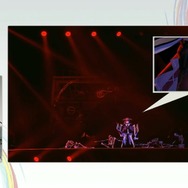

こうしてリアルライブの照明や映像が作られており、観客の目、現実のステージを撮影している実写カメラ、3DCG空間のステージを捉えるバーチャルカメラ、加えてARカメラ、4つの視点が混ざり合って構成されています。現実のステージを捉えた実写カメラにくわえ、バーチャル空間のARカメラの映像を混ぜていくことで、バーチャルアーティストを三次元的に合成していくのです。

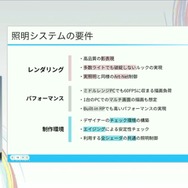

同じような照明効果で撮影すれば同じようなルックを撮影できるとかのようにおもえますが、じつは生成プロセスごとに異なる照明制御を行なわなければ、色味の出方やタイミングも大きくズレてしまい、大きな違和感が生まれてしまいます。

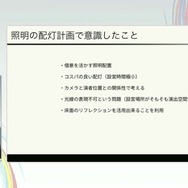

よしださんは、リアルライブの制作においてもっとも重要視しているのは「現地にいらっしゃる観客の肉眼」で、彼らを主たるターゲットとして演出制作しているといいます。ただ一方で、興行的には配信も重要視していて、クオリティも要求されているので、配信を通じて楽しんでもらっているお客様にも満足してもらえるように、整合性もかなり意識していると話されていました。

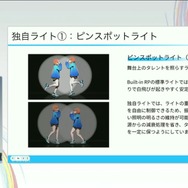

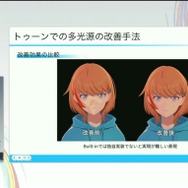

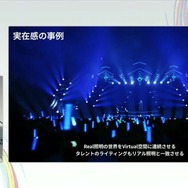

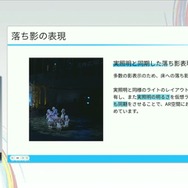

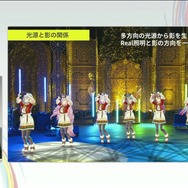

つづいて照明を担当している泉さんからも、実際の取組みについて話が語られました。主役であるタレント本人を美しく引き立つように見せるため、バーチャルライブにおいて一体感に繋がる実在感という部分に話題をフォーカスした話でした。

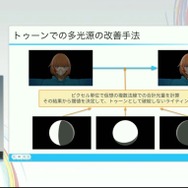

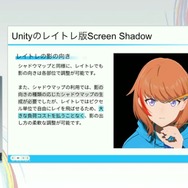

バーチャルの領域でも現実の舞台から照明効果にあわせた照明をあてており、あえて現実の舞台からの影響を反映することで実在感を高められると考え、実践していると泉さんは話します。